Contenu

- Différence principale

- Tableau de comparaison

- Qu'est ce que le Gigabit?

- Qu'est-ce qu'un gigaoctet?

- Différences Clés

Différence principale

L'unité d'information est très différente de l'autre type et doit donc être comprise de manière plus compliquée. Les deux termes discutés ici, Gigabit et Gigabyte, peuvent être expliqués conformément aux définitions du Standard international de mesure, selon lesquelles Gigabit est une unité d’information dix sur dix, ou, en termes exacts, 2 sur trente. morceaux. Alors que, Gigabyte est le terme qui est utilisé comme multiple pour le terme octet et peut être défini comme une unité d’information égale à dix sur la puissance neuf ou, en termes exacts 2, à la puissance trente octets.

Tableau de comparaison

| Base | Gigabit | Gigaoctet |

| Définition | Une unité d’information qui est dix au pouvoir neuf. | Une unité d’information qui est dix au pouvoir neuf. |

| Espace numérique | Égal à 1 000 000 000 bits | Égale à 1 000 000 000 octets |

| Espace binaire | 2 élevés à la puissance 30 bits qui sont égaux à 1 073 741 824 bits. | 2 élevé à la puissance 30 octets qui est égal à 1 073 741 824 octets. |

| Usage | Rare | Commun |

| Unité | Gb ou Gbit | GB |

| Taille | Plus petit | 8 fois plus grand |

| Exemples | Hébergement de serveur dédié. | Espace disque, RAM et bande passante |

Qu'est ce que le Gigabit?

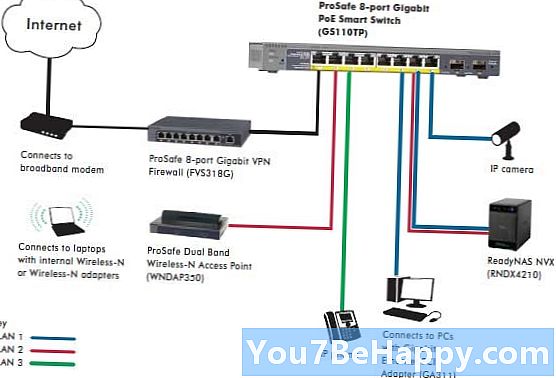

Il s’agit d’une unité d’information qui est dix fois la puissance neuf ou, en termes exacts, 2 qui est élevée à la puissance trente bits. Il est considéré comme la forme la plus importante du terme bit en plusieurs multiples et est utilisé pour des informations numériques telles que des vidéos, des images et d'autres types. Il est également utilisé dans le stockage de l'ordinateur ou d'autres périphériques tels qu'un lecteur USB ou un DVD. La principale capture dans ce mot est Giga, qui est définie comme l'unité qui est toujours élevée à la puissance neuf, ce qui est également connu comme un milliard, ou en nombre de 1.000.000.000. L'unité centrale de Gigabit est Gb, mais il est également écrit Gbit dans certains cas, ce qui ne la confond pas avec d'autres termes similaires qui utilisent le mot Giga. Pour donner aux gens une meilleure idée de la taille, si nous utilisons l’octet unique comme norme, ce qui correspond à 8 bits, un gigabit équivaut à 125 mégaoctets. Il est proche du terme gibibit, qui provient du terme préfixe binaire gibi et a le même ordre de grandeur qu'un gigabit et est égal à 2 sur la puissance 30 bits, ce qui correspond à 1 073 741 824 bits. Pour l'expliquer un peu plus, ce terme est également utilisé dans la partie réseau, dans laquelle il y a un Gigabit Ethernet, c'est un terme qui décrit plusieurs technologies qui transmettent à partir de la trame Ethernet à un débit de 1 Go par seconde, qui devient 1 milliard de bits en une seconde.

Qu'est-ce qu'un gigaoctet?

Ce terme est utilisé comme multiple pour le terme octet et peut être défini comme une unité d’information égale à dix sur la puissance neuf ou, en termes exacts, 2 sur une puissance de trente octets. Le symbole central utilisé pour ce terme est GB. Ce terme est très connu dans plusieurs domaines de la vie tels que l'informatique, l'ingénierie, le commerce et d'autres domaines dans lesquels des données doivent être transférées ou utilisées. En informatique, il est également utilisé de manière différente: il a le même ordre de grandeur qu'un gigaoctet et est égal à 2 élevé à la puissance 30 octets, ce qui correspond à 1 073 741 824 octets. Ce terme est plus gros que le terme Gigabit puisqu'un octet contient environ 8 bits. La définition la plus courante de ce terme est qu'il est 100 élevé au pouvoir 3 et est utilisé dans la description de nombreuses choses telles que même les films. Un film habituel sera de la taille ou d’environ 4 à 8 Go. Par conséquent, beaucoup de gens ont une idée de ce que cela signifie mais ne savent pas exactement quelle est leur explication. Ce terme a été adopté par la commission électrotechnique internationale en 1997 et ajouté comme unité appropriée par l'IEEE en 2009. Comme expliqué précédemment, il existe deux définitions du mot, l'une est sous la forme décimale dans laquelle est égal à 1 milliard d'octets et le second est la définition binaire dans laquelle il est égal à 2 élevé à la puissance 30 octets. Le nombre deux est utilisé en raison du facteur binaire.

Différences Clés

- Les termes Gigabit et Gigabyte sont les unités de mesure de l'espace de stockage numérique.

- Le terme Gigabit a une unité de Go ou de Gbit tandis que le terme Gigabyte a les unités de GB.

- Un gigaoctet est supérieur à un gigabit en ce qui concerne l'espace de stockage fourni par un octet contenant 8 bits.

- Le terme le plus couramment utilisé parmi les deux est Gigabyte, qui est utilisé pour les films et les tailles de vidéo, tandis que Gigabit est moins utilisé en comparaison par des personnes.

- Un gigaoctet est égal à 1 000 000 000 octets, tandis qu'un gigabit est égal à 1 000 000 000 bits à des fins numériques.

- Pour les utilisations binaires, le gigaoctet peut être défini comme une quantité égale à 2 élevée à l'octet de puissance 30, soit égale à 1 073 741 824 octets, tandis qu'un gigabit égal à 2 augmenté à la puissance 30 bits, égale à 1 073 741 824 bits.

- Le gigaoctet est principalement utilisé pour l'espace disque, la RAM et la bande passante, tandis qu'un gigabit est principalement utilisé pour l'hébergement de serveurs dédiés.